EU AI Act و تاثیر آن روی تحلیل تصویر، تشخیص چهره و نظارت عمومی

یک صحنه ساده را تصور کن: یک شهر اروپایی، یک ایستگاه قطار شلوغ، دوربین های شهری، و یک تیم امنیتی که می خواهد با تحلیل تصویر، ازدحام را مدیریت کند و خطرات را زودتر تشخیص دهد. همه چیز از نظر تکنیکی جذاب است. اما درست همان لحظه که کسی می گوید “اگر تشخیص چهره هم اضافه کنیم، خیلی بهتر می شود”، بحث از امنیت عملیاتی می رود سمت قانون، اعتماد عمومی و خط قرمزهای نظارت.

جدول عناوین این مقاله

ToggleEU AI Act دقیقا به همین نقطه ها حساس است. یعنی جایی که AI از یک ابزار کمکی تبدیل می شود به تصمیم گیر، طبقه بندی کننده یا رصدکننده انسان ها در مقیاس گسترده. این مقاله کمک می کند بفهمی EU AI Act در عمل برای تحلیل تصویر، تشخیص چهره و نظارت عمومی چه معنا دارد، چه مواردی پرریسک یا ممنوع می شوند، و چطور با طراحی درست، ریسک حریم خصوصی و ریسک انطباق را پایین بیاوری.

هدف این متن این نیست که شما را با اصطلاحات حقوقی خسته کند. هدف این است که بتوانی یک پروژه نظارتی را طوری طراحی کنی که هم ارزش عملیاتی بدهد و هم از همان روز اول قابل دفاع باشد.

EU AI Act در یک نگاه برای تیم های امنیت، IT و مدیریت

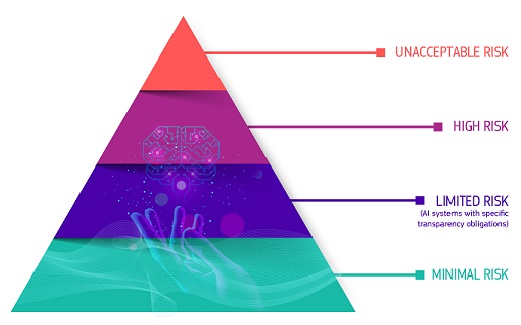

اگر بخواهیم خیلی ساده بگوییم، EU AI Act یک چارچوب “ریسک محور” است. یعنی هر کاربرد AI را بر اساس میزان اثرش روی حقوق افراد، ایمنی و آزادی ها دسته بندی می کند. در نتیجه، بعضی کاربردها تقریبا خط قرمز می شوند، بعضی کاربردها “High-Risk” هستند و باید الزامات سختگیرانه بگذرانند، و بعضی کاربردها هم فقط شفافیت و اطلاع رسانی می خواهند.

حالا چرا این موضوع برای نظارت تصویری مهم است؟ چون نظارت تصویری همیشه دو لایه دارد: لایه امنیت فیزیکی و لایه داده. وقتی AI وارد می شود، آن لایه داده پررنگ تر می شود. سیستم دیگر فقط “ضبط” نمی کند، بلکه “تفسیر” می کند. همین تفسیر است که ریسک را بالا می برد.

از سوی دیگر، خیلی از پروژه ها ناخواسته از یک کاربرد کم ریسک شروع می کنند و بعد آرام آرام به سمت کاربردهای حساس می روند. مثلا اول فقط تشخیص حرکت، بعد شمارش افراد، بعد تحلیل ازدحام، بعد شناسایی الگو، و بعد ایده تشخیص چهره. اگر از ابتدا خط قرمزها و مرزبندی ها روشن نباشد، پروژه در میانه راه گیر می کند.

بنابراین یک نگاه مدیریتی لازم است: قبل از خرید یا فعال کردن قابلیت های AI در VMS، باید دقیقا بدانید “چه کاری” قرار است انجام شود و اثرش روی مردم چیست. همین یک جمله ساده، کیفیت تصمیم گیری را چند برابر می کند.

تحلیل تصویر در AI Act: از تشخیص حرکت تا تحلیل رفتار

“تحلیل تصویر” یک واژه کلی است. برای انطباق، باید آن را خرد کنید. چون تشخیص حرکت با تحلیل رفتار متفاوت است، و تحلیل رفتار با رتبه بندی ریسک افراد کاملا فرق دارد.

در پروژه های معمول، تحلیل تصویر این موارد را شامل می شود: تشخیص حرکت، عبور از خط، ورود به محدوده ممنوع، شمارش افراد، تشخیص ازدحام، تشخیص اشیای رها شده، یا تشخیص خودرو. اینها معمولا روی “رخداد” تمرکز دارند، نه روی “هویت انسان”. به همین دلیل معمولا کنترل پذیرترند و می شود آنها را با طراحی درست کم ریسک کرد.

اما یک نقطه حساس وجود دارد: وقتی تحلیل تصویر شروع می کند به “نتیجه گیری درباره انسان”. مثلا اینکه این فرد مشکوک است، این فرد احتمال جرم دارد، این فرد عصبی است، یا این فرد به یک گروه خاص تعلق دارد. این نوع خروجی ها هم از نظر اخلاقی حساس هستند و هم از نظر ریسک انطباق.

یک قاعده کاربردی: هرچه خروجی شما شبیه یک “قضاوت” درباره افراد شود، باید انتظار الزامات سنگین تر را داشته باشید. بنابراین اگر تحلیل تصویر شما فقط برای مدیریت ازدحام است، خروجی را در سطح “عدد و رخداد” نگه دارید، نه “برچسب انسانی”.

از طرف دیگر، حتی در کاربردهای ساده هم باید از همان ابتدا به حداقل سازی فکر کنید: آیا واقعا لازم است همه فریم ها با کیفیت بالا تحلیل شوند؟ آیا می شود فقط روی مناطق حساس تحلیل انجام داد؟ آیا می شود خروجی را به صورت آمار تجمیعی نگه داشت و نه خروجی فردمحور؟ این تصمیم ها معمولا هم ریسک را کم می کنند و هم هزینه را.

تشخیص چهره: مرزبندی ها، خط قرمزها و اشتباهات رایج

تشخیص چهره جذاب است چون وعده می دهد “همه چیز را خودکار” کند. اما همین جذابیت، بزرگ ترین ریسک است. چون تشخیص چهره معمولا پای هویت افراد را وسط می کشد و هویت یعنی حساسیت.

اینجا سه اشتباه رایج رخ می دهد. اشتباه اول این است که تیم فنی تشخیص چهره را مثل یک ویژگی ساده نرم افزاری می بیند، در حالی که از نظر اثر اجتماعی و حقوقی، این یک تغییر بنیادین در ماهیت نظارت است. اشتباه دوم این است که پروژه بدون هدف دقیق جلو می رود و آخرش معلوم نیست تشخیص چهره برای چه تصمیمی استفاده می شود. اشتباه سوم این است که دیتاست و فرآیند ساخت پایگاه داده چهره جدی گرفته نمی شود.

اگر بخواهیم عملی نگاه کنیم، باید تشخیص چهره را به چند بخش بشکنیم:

تشخیص وجود چهره (فقط اینکه چهره در تصویر هست)

استخراج ویژگی های چهره (تبدیل چهره به الگو یا بردار)

تطبیق با دیتابیس (شناسایی یا تایید هویت)

استفاده از نتیجه برای اقدام (کنترل دسترسی، هشدار، یا پیگیری)

هرچه جلوتر می روید، حساسیت بیشتر می شود. بنابراین حتی اگر سازمان شما “تشخیص چهره” را به زبان ساده می گوید، در DPIA یا ارزیابی داخلی باید دقیقا بگویید کدام مرحله فعال است.

یک نکته خیلی مهم: ساخت یا گسترش دیتابیس چهره، مخصوصا اگر منبع داده روشن نباشد یا از تصاویر عمومی ویدیو به شکل گسترده جمع آوری شود، یکی از پرخطرترین مسیرهاست. اگر سازمان قرار است دیتابیس داشته باشد، باید پاسخ بدهد این چهره ها از کجا آمده اند، با چه مجوزی، برای چه هدفی، و با چه دوره نگهداری.

در عمل، اگر می خواهید ریسک را کم کنید، دو کار خیلی اثر دارد: اول، تشخیص چهره را فقط به سناریوهای محدود و قابل دفاع گره بزنید. دوم، دامنه را کوچک کنید: فقط همان ورودی، فقط همان ساعت های خاص، فقط همان گروه مجاز. محدودیت های زمانی و مکانی، ریسک را واقعی پایین می آورد.

نظارت عمومی: تفاوت محیط کار، فضای عمومی و مکان های حساس

“نظارت عمومی” یک عبارت بزرگ است و از بیرون شبیه یک چیز واحد دیده می شود. اما در عمل سه محیط داریم که باید جدا دیده شوند: محیط کار، فضای عمومی شهری، و مکان های حساس مثل مدارس، بیمارستان ها یا حمل و نقل عمومی.

در محیط کار، مشکل اصلی معمولا “عدم توازن قدرت” است. کارمند می گوید من مجبورم اینجا باشم. بنابراین حتی اگر هدف امنیتی باشد، کاربردهای AI که حالت ارزیابی روانی یا رفتاری پیدا کنند، سریع حساس می شوند. به همین دلیل در طراحی باید به حداقل سازی و شفافیت بیشتر فکر کنید: زاویه دید، عدم تمرکز روی افراد، و جلوگیری از خروجی های فردمحور.

در فضای عمومی شهری، حساسیت بیشتر است چون تعداد افراد زیاد است و رضایت گیری عملی نیست. بنابراین مشروعیت پروژه باید از طریق ضرورت، تناسب، شفافیت و کنترل های فنی تامین شود. اگر شما می خواهید ازدحام را مدیریت کنید، خروجی باید “مدیریتی” باشد، نه “هویتی”. یعنی همان چیزی که به عملیات کمک کند، بدون اینکه مردم احساس کنند در حال شناسایی شدن هستند.

در مکان های حساس، حتی یک خطای طراحی می تواند بحران اعتماد بسازد. مثلا در مدرسه، یک قابلیت ساده تحلیل رفتار می تواند به انگ زنی یا استرس والدین تبدیل شود. بنابراین در این محیط ها بهتر است از ابتدا سقف پروژه را پایین بگیرید: کمتر، محدودتر، و قابل توضیح تر.

یک اصل کاربردی برای نظارت عمومی: هر جا مردم انتظار حریم بیشتری دارند یا قدرت انتخاب کمتری دارند، باید کنترل های بیشتری اعمال کنید. این همان چیزی است که بعدها در گزارش ها و ارزیابی ها به کمک شما می آید.

وقتی سیستم شما High-Risk می شود: الزامات اجرایی به زبان ساده

در بسیاری از پروژه ها، سوال اصلی این نیست که “AI داریم یا نداریم”، سوال این است که “آیا این کاربرد High-Risk حساب می شود یا نه؟”. اگر High-Risk شوید، باید آماده یک بسته کامل مدیریت ریسک باشید. اینجا یک نسخه عملی از آن بسته را می دهم، با زبان پروژه.

اول، باید بتوانید هدف و دامنه را دقیق بنویسید. یعنی سیستم برای چه کاری طراحی شده، در چه مکان هایی، با چه ورودی هایی، و چه خروجی هایی تولید می کند. خروجی باید قابل اندازه گیری باشد، نه مبهم.

دوم، باید مدیریت ریسک مستند داشته باشید. یعنی ریسک ها را لیست کنید، احتمال و شدت را بسنجید، و برای هر ریسک یک کنترل مشخص تعریف کنید. کنترل یعنی یک اقدام قابل اجرا، نه یک جمله کلی.

سوم، باید کیفیت داده و عملکرد را کنترل کنید. در تحلیل تصویر و تشخیص چهره، کیفیت یعنی نرخ خطا، شرایط نور، زاویه، و سناریوهای شکست. اگر سیستم در شرایط خاص خطای بالا دارد، باید محدودش کنید یا برای آن شرایط تصمیم انسانی بگذارید.

چهارم، باید “نقش انسان” را درست تعریف کنید. سیستم نباید به تنهایی حکم صادر کند. در پروژه های نظارتی، بهترین مدل این است: AI هشدار می دهد، انسان تصمیم می گیرد. علاوه بر این، باید آموزش دهید که اپراتور چطور با هشدار غلط برخورد کند تا سیستم تبدیل به ابزار آزار یا تعقیب بی دلیل نشود.

پنجم، باید ثبت و لاگ و ردپای تصمیم را داشته باشید. یعنی وقتی یک هشدار ایجاد شد، معلوم باشد چرا ایجاد شد، چه کسی دید، و چه اقدامی شد. این لاگ ها هم برای امنیت خوب است و هم برای پاسخگویی.

ششم، باید شفافیت و اطلاع رسانی را واقعی کنید. مردم باید بدانند چه چیزی فعال است. یک جمله مبهم مثل “این مکان تحت نظارت است” برای سیستم های تحلیلی کافی نیست. شما باید بتوانید با زبان ساده توضیح دهید: تحلیل برای چه هدفی است و چه چیزهایی را دنبال می کند.

خط قرمزها در عمل: چه کارهایی سریع پروژه را پرریسک یا غیرقابل دفاع می کند

در تجربه پروژه های نظارتی، چند رفتار هست که تقریبا همیشه پروژه را وارد بحران می کند، حتی اگر نیت شما خوب باشد.

اول، جمع آوری بی هدف: یعنی “فعلا ذخیره کنیم، بعدا استفاده می کنیم”. این مدل در AI بسیار خطرناک است، چون وسوسه توسعه کاربردها را بالا می برد و توجیه پذیری را نابود می کند.

دوم، ساخت دیتابیس چهره با منابع نامشخص: اگر نتوانید بگویید چهره ها از کجا آمده اند و چرا، عملا روی یک مین حرکت می کنید.

سوم، اضافه کردن تحلیل های شبه روانشناسی: مثل حدس احساس، قصد، یا شخصیت. حتی اگر تکنولوژی جذاب باشد، اثر اجتماعی آن سنگین است و به سرعت اعتماد را می سوزاند.

چهارم، خروجی های فردمحور بدون کنترل انسانی: یعنی سیستم یک فرد را پرچم می کند و همان پرچم مستقیم باعث اقدام می شود. اینجا احتمال تبعیض، خطای عملیاتی و شکایت بالا می رود.

پنجم، دسترسی باز و بدون لاگ: اگر هرکس بتواند جستجو کند، خروجی بگیرد یا داده را منتقل کند، ریسک شما فقط قانونی نیست، امنیتی هم هست.

اگر هدف شما کاهش ریسک است، این پنج مورد را مثل آژیر خطر ببینید و از ابتدا جلویشان را بگیرید.

طراحی کاهش ریسک: Privacy by Design برای ویدیو و بیومتریک

کاهش ریسک فقط با یک سند اتفاق نمی افتد. باید در طراحی بنشیند. اینجا چند تصمیم طراحی می دهم که هم عملیاتی است و هم اثرش مستقیم است.

اول، محدود کردن میدان دید و مناطق تحلیل. شما می توانید دوربین داشته باشید، اما تحلیل را فقط روی یک ناحیه کوچک اجرا کنید. مثلا فقط روی درب ورود، نه روی کل سالن. این کار هم هزینه پردازش را کم می کند و هم اثر حریم خصوصی را پایین می آورد.

دوم، حداقل سازی خروجی. به جای اینکه خروجی شما “شناسه فرد” باشد، خروجی را “رخداد” کنید. مثلا “عبور از خط” یا “تجمع بیش از حد”. هرچه کمتر به هویت نزدیک شوید، ریسک پایین تر است.

سوم، کاهش نگهداری داده های تحلیلی. خیلی وقت ها خود ویدیو دوره نگهداری دارد، اما داده های تحلیلی مثل لاگ هشدارها هم نگهداری می شوند. باید مشخص کنید کدام بخش واقعا لازم است و کدام بخش فقط حجم و ریسک می سازد.

چهارم، جداسازی دسترسی ها. تیم عملیات شاید باید هشدارها را ببیند، اما تیم دیگر نباید بتواند دیتابیس چهره را مدیریت کند. نقش ها را تفکیک کنید تا سوءاستفاده سخت شود.

پنجم، تست سناریوهای شکست. سیستم های تحلیل تصویر همیشه خطا دارند. شما باید بدانید خطا کجا خطرناک می شود. مثلا خطای تشخیص در ازدحام شاید قابل تحمل باشد، اما خطای تطبیق چهره می تواند یک فرد بی گناه را هدف بگیرد. بنابراین سطح حساسیت را بر اساس اثر تصمیم تنظیم کنید.

اینها همان چیزهایی است که باعث می شود پروژه هم کار کند و هم قابل دفاع بماند.

نقشه راه 90 روزه برای سازمان ها: از تصمیم تا اجرای کم ریسک

اگر الان سازمان شما می خواهد AI را وارد نظارت تصویری کند، این نقشه راه ساده کمک می کند در 90 روز، یک مسیر قابل دفاع بسازید.

در 30 روز اول، دامنه را مشخص کنید. یک صفحه بنویسید: هدف، مکان ها، نوع تحلیل، خروجی، و کسانی که خروجی را می بینند. سپس یک ارزیابی ریسک سبک انجام دهید و تصمیم های طراحی را همانجا بگیرید: محدودیت مکانی، محدودیت زمانی، عدم استفاده از صدا، و سیاست نگهداری.

در 30 روز دوم، کنترل های فنی را پیاده کنید. نقش بندی دسترسی، فعال سازی لاگ، محدود کردن خروجی گرفتن، تنظیم دوره نگهداری، و اگر لازم است ماسک کردن بخش های حساس تصویر. سپس یک تست واقعی انجام دهید: چند روز هشدارها را ببینید و نرخ هشدار غلط را بسنجید.

در 30 روز سوم، حاکمیت را کامل کنید. اطلاع رسانی شفاف، دستورالعمل اپراتورها، فرآیند رسیدگی به اعتراض یا درخواست، و برنامه بازبینی دوره ای. سپس یک سناریوی تمرینی اجرا کنید: اگر هشدار غلط زیاد شد چه می کنیم؟ اگر درخواست دسترسی مطرح شد چه می کنیم؟ اگر نیاز شد قابلیت را خاموش کنیم، چه کسی تصمیم می گیرد؟

نتیجه این مسیر این است که پروژه به جای یک “ویژگی هیجان انگیز”، تبدیل می شود به یک سرویس قابل مدیریت.

جمع بندی: چطور از AI در نظارت استفاده کنیم بدون اینکه اعتماد عمومی را بسوزانیم

EU AI Act و تاثیر آن روی تحلیل تصویر، تشخیص چهره و نظارت عمومی یک پیام ساده دارد: AI وقتی وارد رصد انسان می شود، باید با احتیاط، شفافیت و کنترل طراحی شود. اگر شما هدف را دقیق کنید، خروجی را رخدادمحور نگه دارید، دسترسی ها را نقش محور کنید، نگهداری را محدود کنید، و کنترل انسانی را جدی بگیرید، هم ارزش عملیاتی می گیرید و هم ریسک را پایین می آورید.

در نهایت، پروژه های نظارتی موفق آنهایی نیستند که “بیشترین قابلیت” را دارند، پروژه های موفق آنهایی هستند که مردم می توانند بفهمند چرا وجود دارند و چرا منصفانه طراحی شده اند.

EU AI Act و تاثیر آن روی تحلیل تصویر، تشخیص چهره و نظارت عمومی دقیقا شامل چه چیزهایی می شود؟

EU AI Act روی “کاربرد” تمرکز دارد، نه فقط روی تکنولوژی. یعنی ممکن است یک مدل تحلیل تصویر در یک سناریو کم ریسک باشد و در سناریوی دیگر پرریسک یا حتی غیرقابل دفاع. برای پروژه های نظارتی، موضوعات اصلی معمولا اینهاست: آیا سیستم به هویت افراد نزدیک می شود؟ آیا در فضای عمومی و در مقیاس بزرگ اجرا می شود؟ آیا خروجی می تواند باعث اقدام علیه افراد شود؟ اگر پاسخ به این سوال ها مثبت باشد، باید انتظار کنترل ها و الزامات سخت تر را داشته باشید. بهترین رویکرد این است که از ابتدا کاربرد را محدود، شفاف و قابل توضیح طراحی کنید.

آیا هر نوع تشخیص چهره در اروپا ممنوع است؟

تشخیص چهره یک طیف است و همه چیز به “نوع استفاده” و “زمینه اجرا” برمی گردد. بعضی سناریوها ممکن است با محدودیت های شدید یا الزامات سنگین مواجه شوند، مخصوصا وقتی پای فضای عمومی، مقیاس بزرگ و اثر مستقیم روی افراد وسط باشد. اما بعضی سناریوهای محدود مثل کنترل دسترسی در محیط های خاص، اگر با طراحی درست، حداقل سازی و کنترل های قوی همراه شوند، مسیر متفاوتی دارند. نکته کلیدی این است که پروژه باید هدف روشن، کنترل انسانی، و سیاست داده دقیق داشته باشد.

تحلیل تصویر برای مدیریت ازدحام یا ایمنی هم پرریسک حساب می شود؟

نه همیشه. اگر تحلیل تصویر شما روی آمار و رخداد تمرکز کند و به هویت افراد نزدیک نشود، معمولا کنترل پذیرتر است. مثلا شمارش افراد، تشخیص ازدحام، یا هشدار ورود به محدوده خطر اگر بدون شناسایی افراد انجام شود، ریسک کمتری دارد. با این حال، همچنان باید حداقل سازی، سیاست نگهداری، کنترل دسترسی و شفافیت را رعایت کنید. یک اشتباه رایج این است که همین کاربردهای ساده بعدا به سمت رصد فردی توسعه داده می شوند، که باید از ابتدا جلوی این لغزش را گرفت.

“نظارت عمومی” دقیقا یعنی چه و چرا حساس است؟

نظارت عمومی یعنی جایی که افراد زیادی در معرض رصد قرار می گیرند و عملا امکان رضایت گیری فردی وجود ندارد. حساسیت از اینجا می آید که اثر اجتماعی بالاست و خطا یا سوءاستفاده می تواند اعتماد عمومی را تخریب کند. به همین دلیل باید ضرورت و تناسب روشن باشد، خروجی ها تا حد ممکن غیرهویتی باشند، و کنترل های فنی مثل محدودیت مکانی و زمانی اعمال شود. هرچه محیط حساس تر باشد، باید محافظه کارتر طراحی کنید.

اگر سیستم فقط هشدار بدهد و تصمیم را انسان بگیرد، ریسک کمتر می شود؟

معمولا بله، چون کنترل انسانی جلوی تصمیم های خودکار و غیرقابل توضیح را می گیرد. اما کافی نیست. شما هنوز باید ببینید هشدار بر چه مبنایی تولید می شود، چقدر خطا دارد، و آیا هشدارها می توانند باعث رفتار تبعیض آمیز یا تعقیب بی دلیل شوند یا نه. بنابراین کنترل انسانی باید همراه با آموزش اپراتور، لاگ تصمیم ها، و معیار روشن برای اقدام باشد. بهترین مدل این است که AI فقط یک ابزار کمک کننده باشد، نه قاضی.

با دیتابیس چهره چه کنیم تا پروژه از اول منفجر نشود؟

اول باید مشخص کنید آیا واقعا به دیتابیس چهره نیاز دارید یا نه. اگر نیاز دارید، منبع داده باید شفاف و قابل دفاع باشد و دامنه استفاده محدود بماند. همچنین باید دوره نگهداری، دسترسی ها، و فرآیند حذف مشخص باشد. یک اشتباه بزرگ این است که دیتابیس را بزرگ کنید چون “ممکن است روزی لازم شود”. این مدل هم ریسک را بالا می برد و هم توجیه پذیری را نابود می کند. دیتابیس چهره باید کوچک، هدفمند و کنترل شده باشد.

برای کاهش ریسک حریم خصوصی در تحلیل ویدیو، مهم ترین سه اقدام چیست؟

اول محدود کردن میدان دید و مناطق تحلیل است، یعنی فقط همان جایی که لازم است تحلیل شود. دوم غیرهویتی کردن خروجی هاست، یعنی خروجی را رخداد و آمار کنید نه شناسه فرد. سوم کنترل دسترسی و لاگ است، یعنی هر مشاهده، جستجو و خروجی گرفتن قابل ردیابی باشد و افراد غیرضروری دسترسی نداشته باشند. اگر همین سه مورد درست اجرا شود، بخش بزرگی از ریسک عملیاتی و ریسک انطباق پایین می آید.

آیا استفاده از Emotion AI روی ویدیو در محیط کار ایده خوبی است؟

در عمل، این نوع کاربردها به شدت حساس هستند چون وارد برداشت درباره حالت روانی افراد می شوند و می توانند به بی اعتمادی و اعتراض تبدیل شوند. حتی اگر تیم فنی بگوید “فقط برای بهبود تجربه” است، کارکنان ممکن است آن را ابزار کنترل ببینند. بنابراین اگر سازمان به فکر چنین قابلیتی است، باید از ابتدا با نگاه بسیار محافظه کارانه، محدودیت های شدید، و بررسی دقیق ضرورت جلو برود. در بیشتر سازمان ها، ارزش عملیاتی این قابلیت نسبت به ریسک آن پایین تر است.

چطور برای یک پروژه نظارت عمومی، یک روایت قابل دفاع بسازیم؟

روایت قابل دفاع یعنی بتوانید در یک صفحه توضیح دهید: مشکل چیست، چرا AI لازم است، چرا روش انتخابی کمترین راه موثر است، چه چیزهایی را رصد می کنید و چه چیزهایی را رصد نمی کنید، داده ها چقدر نگهداری می شوند، چه کسی دسترسی دارد، و مردم چطور مطلع می شوند و چطور سوال می پرسند. اگر این روایت شفاف باشد، هم تصمیم های داخلی بهتر می شود و هم در مواجهه با رسانه، کارکنان یا نهادهای نظارتی دستتان خالی نیست.

آیا EU AI Act فقط برای شرکت های سازنده AI است یا برای مصرف کننده هم اثر دارد؟

برای پروژه های نظارتی، اثر فقط روی سازنده نیست. چون حتی اگر شما “سازنده” نباشید، به عنوان بهره بردار یا سفارش دهنده، باید مطمئن شوید کاربردی که اجرا می کنید قابل دفاع و کم ریسک است. از طرف دیگر، تامین کننده شما هم ممکن است برای فعال کردن برخی قابلیت ها از شما مستندات و محدودیت های استفاده بخواهد. بنابراین بهتر است از ابتدا نقش خودتان را جدی بگیرید: تعریف کاربرد، کنترل های اجرا، آموزش اپراتورها، و پایش مداوم.

خانه » سیستم های امنیتی » EU AI Act و تاثیر آن روی تحلیل تصویر، تشخیص چهره و نظارت عمومی